问答

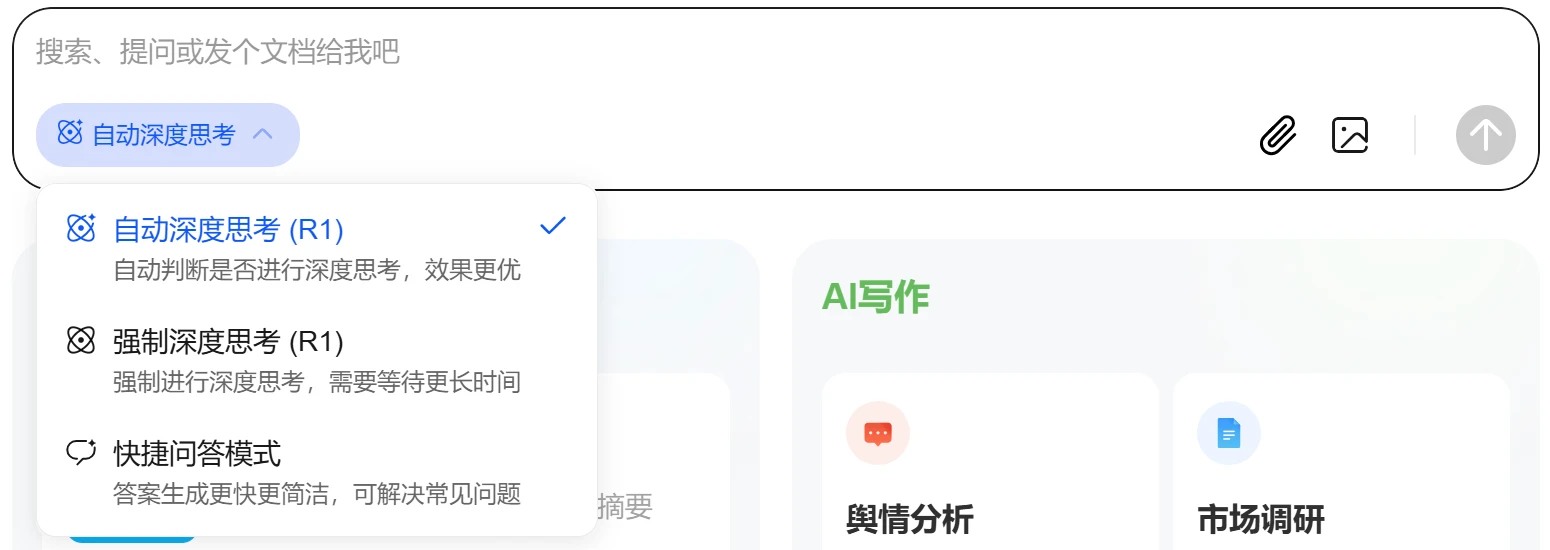

ZeroSearch

ZeroSearch 是阿里巴巴通义实验室开发的基于大模型的搜索引擎框架,通过强化学习技术提升搜索能力,无需依赖真实搜索引擎。它能动态生成相关或噪声文档,显著降低训练成本(超80%),并支持多种模型和算法,适用于问答、内容创作、教育等多个场景。

OmniCorpus

OmniCorpus是上海人工智能实验室联合多家知名高校和研究机构共同创建的一个大规模多模态数据集,包含86亿张图像和16960亿个文本标记,支持中英双语。它通过整合来自网站和视频平台的文本和视觉内容,提供了丰富的数据多样性。OmniCorpus不仅规模庞大,而且数据质量高,适合多模态机器学习模型的训练和研究。它广泛应用于图像识别、视觉问答、图像描述生成和内容推荐系统等领域。

VideoLLaMB

VideoLLaMB 是一个创新的长视频理解框架,通过引入记忆桥接层和递归记忆令牌来处理视频数据,确保在分析过程中不会丢失关键的视觉信息。该模型专为理解长时间视频内容而设计,能够保持语义上的连续性,并在多种任务中表现出色,例如视频问答、自我中心规划和流式字幕生成。VideoLLaMB 能够有效处理视频长度的增加,同时保持高性能和成本效益,适用于学术研究和实际应用。

---