在当今快速发展的AI技术领域,推理优化已成为提升模型性能的关键环节。本专题汇集了24款最具代表性的推理优化工具和资源,通过分类整理和详细介绍,帮助用户快速找到适合自己需求的工具,提高工作和学习效率。我们不仅提供了每款工具的核心功能、适用场景和优缺点分析,还根据综合性能制定了详细的排行榜,指导用户在不同场景下做出最优选择。例如,对于需要高质量视频生成的用户,我们推荐中国首个面向AI短剧创作的视频生成模型;而对于即时内容生成需求,腾讯发布的快思考模型则是理想之选。此外,我们还介绍了如Skywork-VL Reward这样的多模态奖励模型,适用于内容评估和模型对齐等复杂任务。通过本专题,您将深入了解这些工具的独特优势和潜在局限,从而在实际应用中发挥最大效能。无论是科研人员、工程师还是普通用户,都能从中获得宝贵的知识和实用的建议,助力您的AI之旅更加顺畅高效。

专业测评与排行榜

功能对比

- AI短剧创作模型:专注于影视级人物表情和动作生成,适用于影视制作、广告等需要高质量视频生成的场景。

- 腾讯快思考模型:响应速度快,适用于知识问答、数理推理及创作任务,适合即时内容生成需求。

- Skywork-VL Reward:多模态奖励模型,支持图像描述、推理优化等任务,广泛应用于内容评估和模型对齐。

- Granite 4.0 Tiny Preview:轻量级语言模型,适合资源受限环境下的长文本分析和边缘设备部署。

- DeepSeek-R1T-Chimera:开源语言模型,融合了多种优势,适用于智能客服、教育和代码生成等领域。

- MT-TransformerEngine:专为Transformer模型设计的优化框架,提升训练和推理效率,适用于大规模语言模型。

- LanPaint:基于Stable Diffusion的图像修复工具,操作简便,效果自然,适用于艺术创作和图像修复。

- PRefLexOR:自学习AI框架,适用于复杂科学问题解决和持续优化,支持开放域问题解决。

- 3FS:高性能分布式文件系统,适用于大规模AI应用,提供高吞吐量和强一致性。

- 腾讯混元Turbo S:高效AI模型,支持多领域推理和内容创作,适用于对话、代码和逻辑推理。

适用场景与优缺点分析

- AI短剧创作模型:适用于影视制作和广告,优点是高质量的人物表情和动作生成,缺点是对计算资源要求较高。

- 腾讯快思考模型:适用于即时内容生成,优点是响应速度快,缺点是在复杂推理任务中可能表现不如专用模型。

- Skywork-VL Reward:适用于多模态任务,优点是输出与人类偏好一致,缺点是训练数据需求大。

- Granite 4.0 Tiny Preview:适用于资源受限环境,优点是内存需求低,缺点是处理复杂任务能力有限。

- DeepSeek-R1T-Chimera:适用于智能客服和教育,优点是开源且运行速度快,缺点是需进一步优化以提升准确性。

- MT-TransformerEngine:适用于大规模语言模型,优点是提升训练和推理效率,缺点是需配合其他工具使用。

- LanPaint:适用于图像修复和艺术创作,优点是操作简便,缺点是修复效果依赖于输入质量。

- PRefLexOR:适用于复杂科学问题解决,优点是具备自主学习能力,缺点是实现复杂度高。

- 3FS:适用于大规模AI应用,优点是高吞吐量和强一致性,缺点是部署成本高。

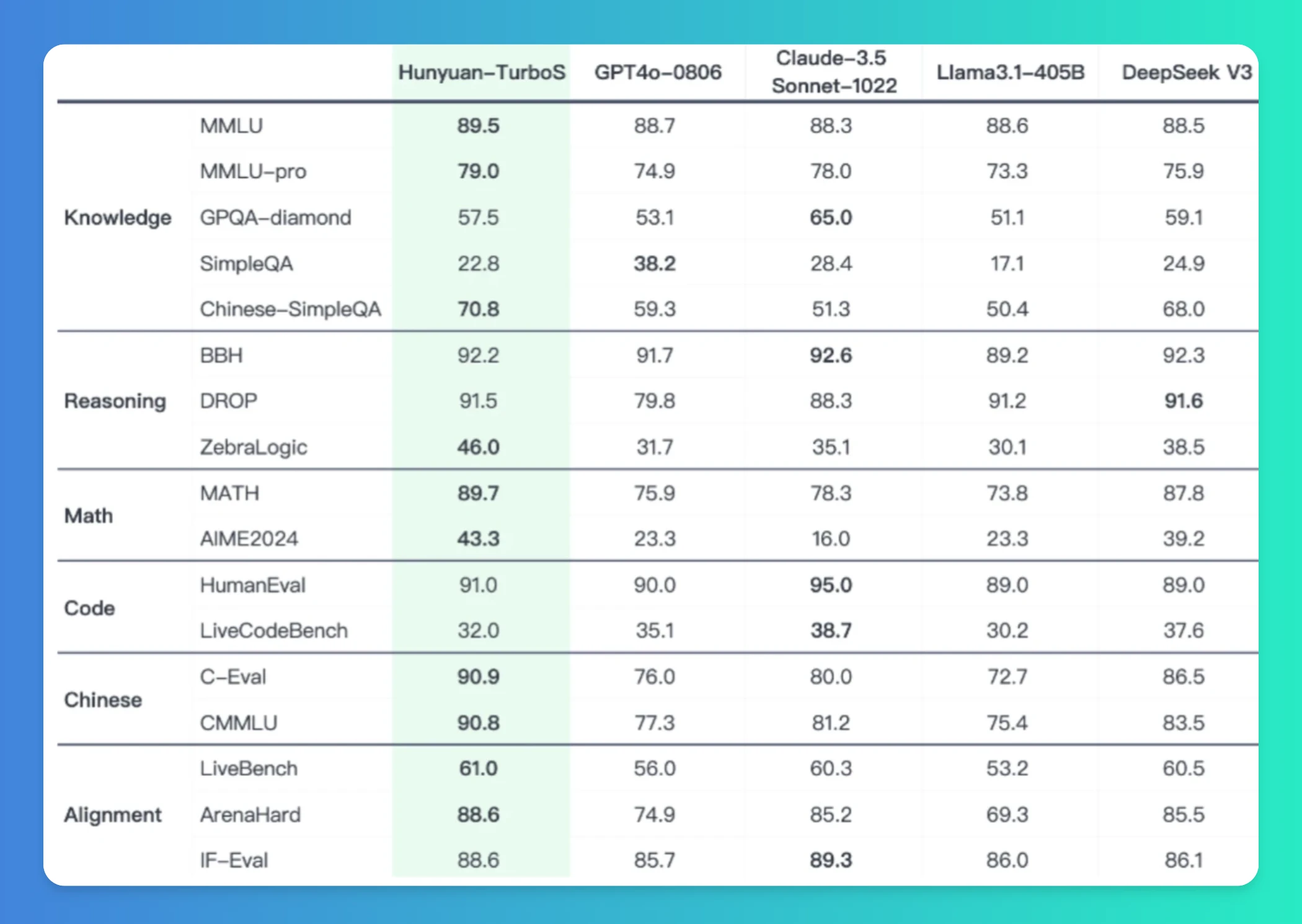

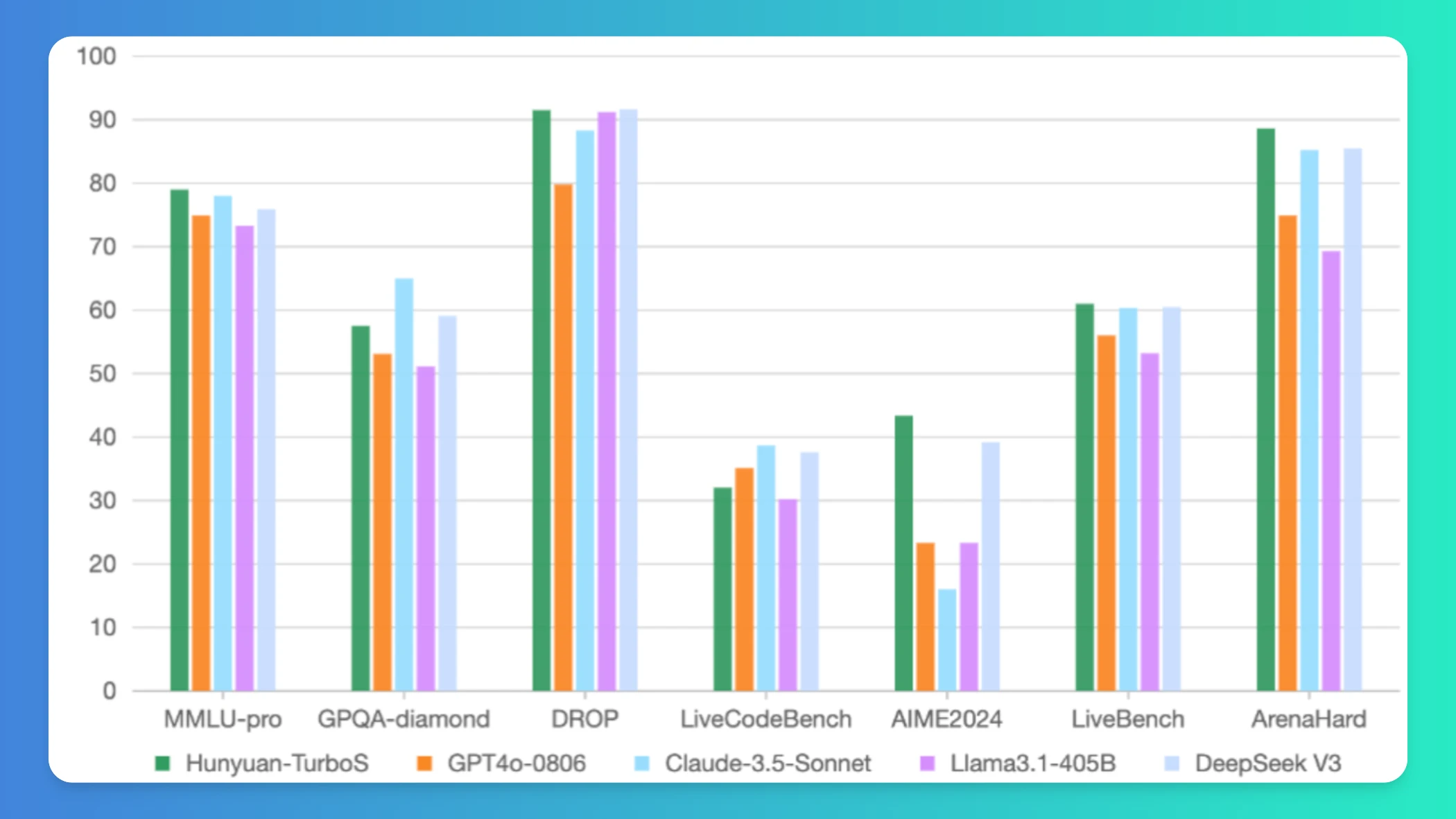

腾讯混元Turbo S:适用于多领域推理和内容创作,优点是支持快速响应,缺点是性能对标行业领先模型。

排行榜(按综合性能排序)

- 腾讯混元Turbo S

- Skywork-VL Reward

- DeepSeek-R1T-Chimera

- MT-TransformerEngine

- LanPaint

- PRefLexOR

- 3FS

- AI短剧创作模型

- Granite 4.0 Tiny Preview

腾讯快思考模型

使用建议

- 对于影视制作和广告,推荐使用AI短剧创作模型。 - 对于即时内容生成,推荐使用腾讯快思考模型。 - 对于多模态任务,推荐使用Skywork-VL Reward。 - 对于资源受限环境,推荐使用Granite 4.0 Tiny Preview。 - 对于智能客服和教育,推荐使用DeepSeek-R1T-Chimera。

KTransformers

KTransformers是一款由清华大学KVCache.AI团队与趋境科技联合开发的开源工具,用于提升大语言模型的推理性能并降低硬件门槛。它支持在24GB显卡上运行671B参数模型,利用MoE架构和异构计算策略实现高效推理,预处理速度达286 tokens/s,推理速度达14 tokens/s。项目提供灵活的模板框架,兼容多种模型,并通过量化和优化技术减少存储需求,适合个人、企业及研究场景使用。

腾讯混元Turbo S

腾讯混元Turbo S是腾讯推出的高效AI模型,采用Hybrid-Mamba-Transformer架构,提升推理效率并降低计算成本。支持快速响应、多领域推理、内容创作及多模态生成,适用于对话、代码、逻辑推理等场景。兼具短思维链与长思维链能力,性能对标行业领先模型。

Granite 4.0 Tiny Preview

Granite 4.0 Tiny Preview是IBM推出的轻量级语言模型,具备高效计算能力和紧凑结构,支持在消费级GPU上运行多个长上下文任务。采用混合Mamba-2/Transformer架构,结合高效与精准优势,支持无位置编码(NoPE)处理128K tokens上下文。内存需求降低72%,推理时仅激活1B参数,适用于边缘设备部署、长文本分析及企业级应用开发,适合资源受限环境下的AI研究与

发表评论 取消回复